Le budget de crawl est une notion clé en SEO. Pourtant, nombreux sont ceux qui peinent à cerner ce qui se cache réellement derrière… Et qui par conséquent le néglige. Or, tenir compte de son existence pour optimiser son site en conséquence est TRÈS important, pour ne pas dire capital !

Dans cet article, notre agence SEO vous propose d’aborder le concept de budget de crawl en SEO : définition d’un crawler, fonctionnement du Googlebot, réserve de crawl… À l’issue de cette lecture, vous serez incollable sur le crawling et disposerez de toutes les clés pour optimiser votre crawl budget. C’est parti !

Qu’est-ce qu’un crawler ?

Comme son nom l’indique, un crawler, aussi appelé robot d’indexation, a pour principale mission le crawl d’un site web. Mais qu’est-ce que cela signifie exactement ?

Tous les sites accessibles via le moteur de recherche Google ont été préalablement crawlés, c’est à dire qu’un robot est passé par là pour parcourir le site et analyser ses contenus. Sans l’existence de ces robots, Google ne serait pas la mine inépuisable d’informations que nous connaissons aujourd’hui et que nous exploitons quotidiennement.

Navigant de lien en lien, les Googlebots arpentent la toile en permanence, 24h/24 et 7j/7. Ces petits logiciels autonomes sont en quête permanente de nouveaux contenus et de mises à jour. Leur but ? Indexer de nouvelles pages et aider le moteur de recherche à les classer selon leur qualité et leur degré de pertinence.

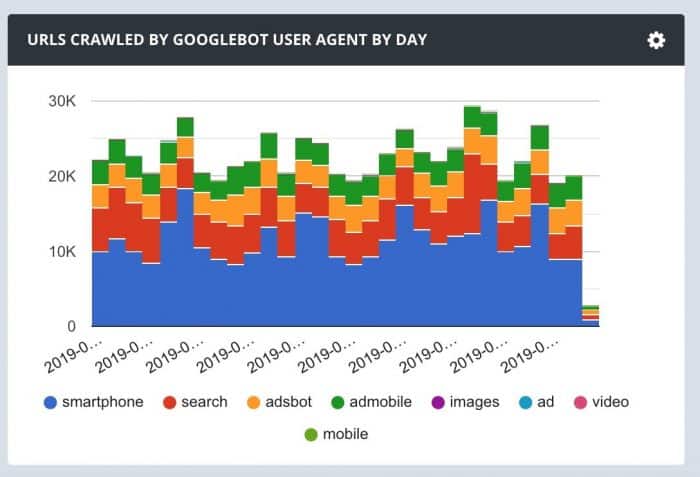

Il existe différents types de crawlers Google afin de couvrir tous les domaines :

- search,

- mobile,

- ads,

- images,

- vidéos…

Présentation de Googlebot

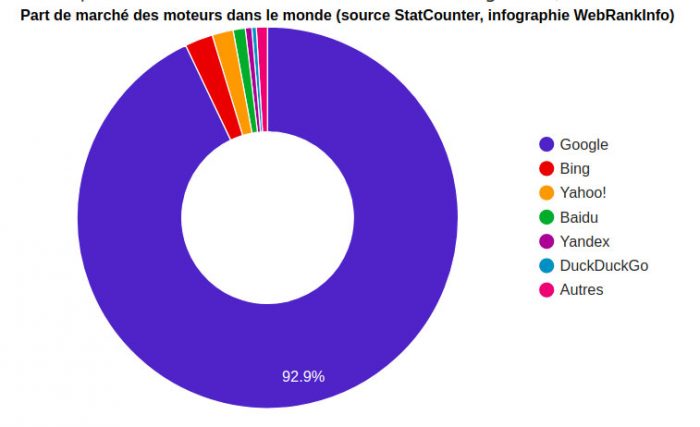

Les robots d’indexation de la firme de Mountain View sont plus communément appelés “ Googlebots “. Chaque moteur de recherche dispose de ses propres outils : Bingbot pour Bing, Slurp pour Yahoo!, Baiduspider pour Baïdu…

Avec une part de marché qui avoisine les 93%, Google est en situation de quasi monopole au niveau mondial.

Source : Webrankinfo

Comprendre comment fonctionne Googlebot est aujourd’hui crucial pour qui souhaite faire indexer son site et obtenir de la visibilité sur internet ! Alors, comment ça marche ?

Le Googlebot a pour principale mission de parcourir le web, soit à partir d’un répertoire d’URL déjà connues, soit depuis les données présentes sur les sitemaps, soit en allant de lien en lien. Pour voir comment GoogleBot visite les différentes parties de votre site web, vous pouvez utiliser le fameux fichier robots.txt. C’est également par le biais de ce fichier que vous pouvez indiquer les URL à ne pas indexer.

Suite au passage d’un Googlebot, la page parcourue ou crawlée est indexée, c’est à dire qu’elle se positionne sur la SERP. À partir de ce moment-là, elle devient visible et donc accessible pour les internautes depuis le moteur de recherche. Attention cependant à ne pas confondre indexation et classement : le Googlebot ne fait que visiter et répertorier les pages, tandis que le classement de ces pages sur la SERP ne dépend pas de lui, mais plutôt d’un ensemble de critères de positionnement SEO énoncés par Google.

Qu’est-ce que le taux limite de crawl ?

Le fait de crawler un site mobilise une certaine quantité de ressources sur le serveur. Au même titre qu’un nombre important de visiteurs présents en simultané sur un site surcharge le serveur et peut impacter les performances du site, un crawl trop important de la part des Googlebots peut être un handicap. Pour cette raison, Google définit pour chaque site un taux limite de crawl : le robot visite un certain nombre de pages en même temps, pas plus. Cela sert à ne pas affecter les performances de chargement, et par conséquent la qualité de la navigation des “ vrais “ visiteurs.

Qu’est-ce que la demande de crawl ?

Réaliser une action de demande de crawl, ou demande d’exploration, peut être utile dans le cas d’un ajout récent d’une page ou de nouvelles modifications apportées à un site.

Si vous ne faites pas de demande de crawl, cela implique que vous devez attendre patiemment le passage du Googlebot. Et cela peut prendre plusieurs jours, ou plusieurs semaines, selon le type de site et la fréquence habituelle du passage du robot.

Très fréquemment mis à jour, les médias, les sites d’actualités chaudes et les marketplaces sont crawlés plusieurs fois par jour par les robots. Mais c’est loin d’être le cas de tous les sites !

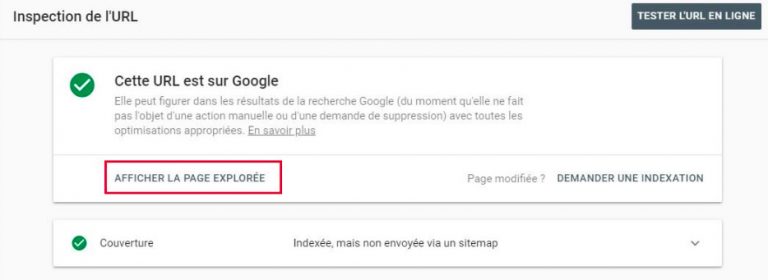

Pour avoir de la visibilité sur l’état de l’exploration de vos pages, l’outil Search Console vous sera d’une précieuse aide. Un outil d’inspection d’URL est aussi à votre disposition.

Pour effectuer une demande de crawl auprès de Google, deux solutions s’offrent à vous :

- soumettre une URL directement à l’index, idéal dans le cas d’une petite quantité de liens à explorer,

- soumettre un sitemap complet, ce qui est la meilleure alternative pour faire une demande d’exploration d’un site web ou d’un grand nombre d’URL.

Qu’est-ce qu’une réserve de budget de crawl ?

Pour mieux appréhender la notion de “ réserve de budget de crawl “, il est important de comprendre que chaque site bénéficie d’une certaine ressource en fonction de sa notoriété, de son importance, de sa fréquence de mise à jour, du nombre de pages qu’il comporte… Plusieurs critères entrent en ligne de compte.

Si votre site comporte des pages en erreur 4XX ou beaucoup de contenus obsolètes, sachez qu’une partie du budget de crawl consacrée à votre site se retrouve donc consommée par l’exploration de ces pages. Cela implique que les Googlebot vont passer du temps à explorer ces pages, qui s’avèrent être inutiles. Et pendant qu’ils sont occupés à cela, ils ne visitent pas d’autres pages, sans doute plus intéressantes et stratégiques pour votre marque. Rien de mieux pour dilapider inutilement votre crawl budget…

Plutôt que de chercher à maximiser le nombre d’URL explorées par Google, focalisez-vous davantage sur toutes les pages explorées inutilement. Mises bout à bout, ces URL constituent certainement une réserve de budget de crawl non négligeable qu’il serait intéressant d’exploiter !

Qu’est-ce qui peut ralentir le crawl de Google ?

Plusieurs éléments influencent directement ou indirectement la fréquence de crawl des robots de Google. L’enjeu est d’identifier rapidement ceux qui affectent directement votre site pour intervenir rapidement.

Parmi les plus fréquents, nous retrouvons :

- les crawlers traps, ou en français “ piège à crawl “. Ces problèmes, plus ou moins importants, de structure du site sont souvent mis en cause et peuvent sérieusement entraver votre SEO. Ils freinent sensiblement le travail des crawlers, comme par exemple dans le cas où il existe une infinité d’URL non pertinentes. Les robots se perdent alors dans les abysses de l’architecture et des pages de votre site plutôt que de converger vers vos pages stratégiques. La navigation à facettes ou les URL paramétrables générées automatiquement sont de bons exemples. Bonjour le gaspillage de crawl budget !

- la fréquence de mise à jour du site. Imaginons que les Googlebots ont pour habitude de passer 4 fois par semaine sur votre site et trouvent toujours du nouveau contenu à indexer. Si vous arrêtez subitement de mettre votre site à jour, les robots vont continuer de s’y rendre mais ne constateront aucune mise à jour au fil de leurs visites. Au bout de plusieurs visites infructueuses, ils prendront l’habitude de venir moins souvent crawler votre site. À contrario, le rafraîchissement régulier du contenu peut d’une certaine manière “ doper “ le crawl de votre site sur cette page.

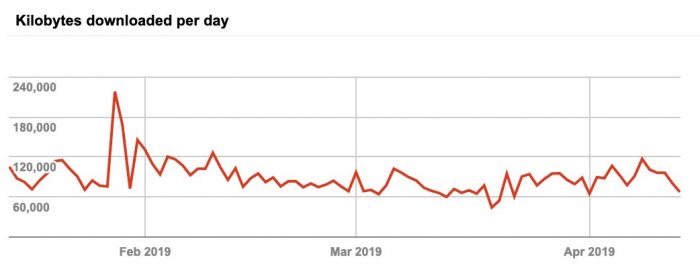

- le temps de chargement du site. Un site lent ne verra que quelques unes de ses pages crawlées à chaque passage d’un crawler, tandis qu’un site performant verra son taux d’exploration augmenter.

- les redirections et boucles de redirections. Véritables voies sans issue pour les robots, ce type de liens gaspille beaucoup de budget de crawl pour rien !

- un niveau d’architecture trop complexe et profond. Ce type de problème implique que des pages peu pertinentes sont visitées, tandis que les plus intéressantes ne le sont pas…

- une mauvaise pagination. Sur un forum par exemple, la visite d’un robot sur les pages 2, 3, 4, 5 n’est pas forcément utile !

- un trop grand nombre de chargements de scripts JavaScript. Long et fastidieux pour les serveurs, le crawl du code JavaScript nécessite la récupération de toutes les ressources et s’avère être un véritable gouffre à crawl budget…

- le contenu dupliqué. Si votre site contient du contenu dupliqué interne, votre crawl budget se consume tout seul car le robot va passer plusieurs fois sur le même contenu… Au même titre que le contenu de faible qualité comme les FAQ consomme du crawl budget inutilement…

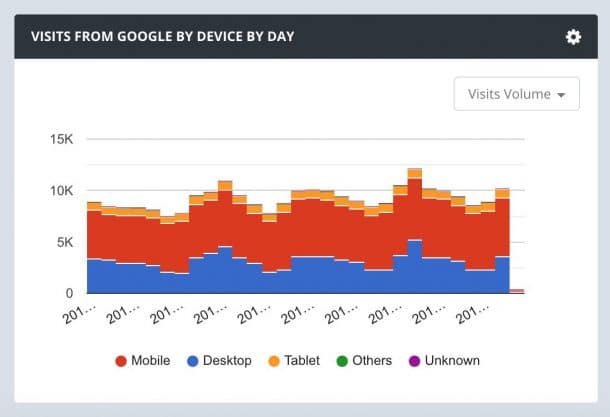

- le Mobile First. Il est important de comparer le passage du Googlebot dédié au mobile avec celui dédié au desktop. Un seul mot d’ordre, plus que jamais : pensez Mobile First !

Un sitemap inexistant ou qui n’a pas été mis à jour alors que des changements ont eu lieu sur le site peuvent aussi être à l’origine d’un ralentissement du crawl de Google.

Pourquoi faut-il se préoccuper du budget de crawl ?

Pour certains webmasters et experts SEO, le budget de crawl ne mérite pas que l’on s’y attarde longtemps. Pour d’autres, cet élément nécessite une attention particulière. Alors, qu’en est-il vraiment ?

Au regard de la quantité astronomique de pages présentes sur internet, les crawlers sont contraints d’accorder une ressource d’exploration préalablement définie – et surtout inextensible – à chaque site web. Hé oui, il en faut pour tout le monde ! Vous souhaitez que votre site, et plus précisément vos pages stratégiques, soient indexés rapidement ? Alors pensez à optimiser votre budget crawl.

Pour constater les effets bénéfiques de l’optimisation de votre budget de crawl, la technique est simple : comparez le nombre de nouvelles pages crawlées avant VS après l’optimisation.

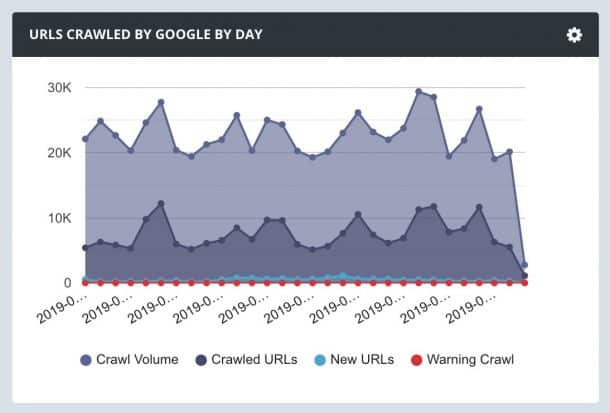

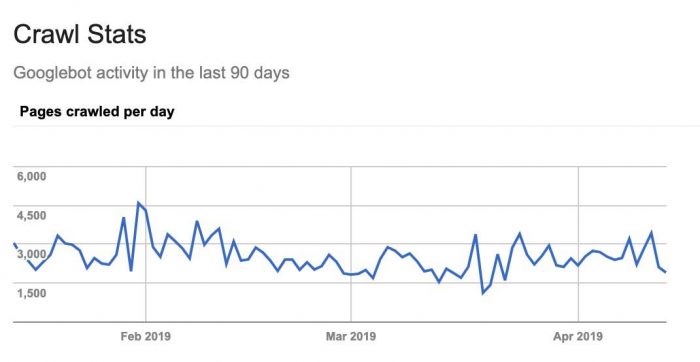

Combien d’URL de mon site sont explorées chaque jour ?

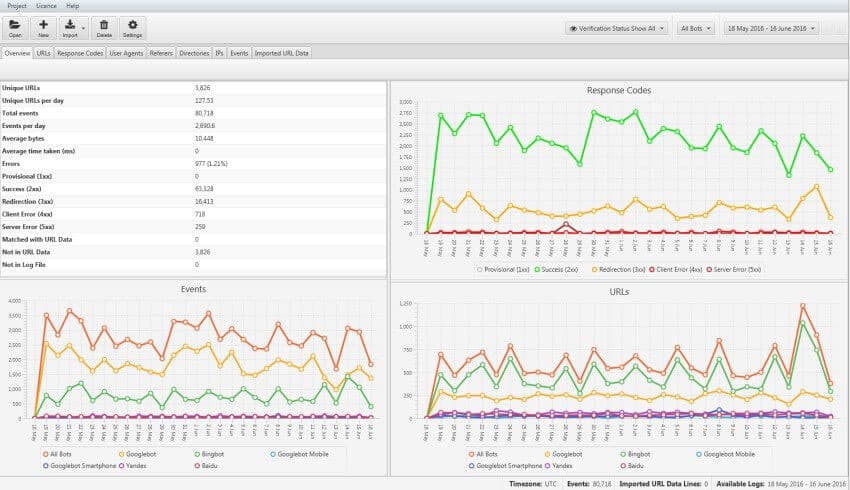

Pour connaître précisément le nombre d’URL crawlées par Google, l’analyse des fichiers de logs est la méthode la plus infaillible, et pour cause : elle permet de savoir quelle image de votre site est renvoyée aux moteurs de recherche. Cette analyse permet entre autres de collecter des informations telles que les pages, catégories et parties du site crawlées, la fréquence de crawl et les informations reçues sur ces différentes pages.

Comme souvent, la fameuse Search Console vous apportera également des informations très importantes sur le crawling de votre site.

Vous préférez étudier le crawl de vos pages une par une ? L’inspecteur d’URL présent dans la Search Console sera votre meilleur ami ! Les retours de l’outil sur la page en question vous donneront un aperçu des axes d’amélioration à poursuivre.

Comment optimiser votre budget de crawl ?

Au regard de tous les éléments énoncés précédemment dans cet article, il existe plusieurs techniques qui combinées permettent d’améliorer significativement son budget de crawl. Dans une optique d’optimisation SEO, il convient de réfléchir à comment économiser cette précieuse ressource qu’est le budget de crawl.

Identifier les pages qui consomment inutilement du budget de crawl

Sur presque tous les sites, de nombreuses pages sont crawlées par les robots alors qu’elles n’auraient pas besoin de l’être. Ce gaspillage de budget de crawl entrave également la performance SEO du site.

Par le biais de la Search Console, vous pouvez voir le nombre de pages qui sont crawlées mais ne sont pas indexées. Cette donnée offre un premier aperçu du budget de crawl qui pourrait être consacré à d’autres pages plus importantes et stratégiques. Mais c’est véritablement grâce à l’analyse de logs que vous pourrez savoir précisément le volume de budget de crawl gâché. La technique consiste à comparer le nombre de pages crawlées au nombre de pages total du site pour identifier :

- quel pourcentage du site est crawlé ?

- quelles sont les pages stratégiques pour votre SEO qui ne sont pas crawlées ?

- quelles pages consomment inutilement du budget de crawl ?

Source : Screamingfrog

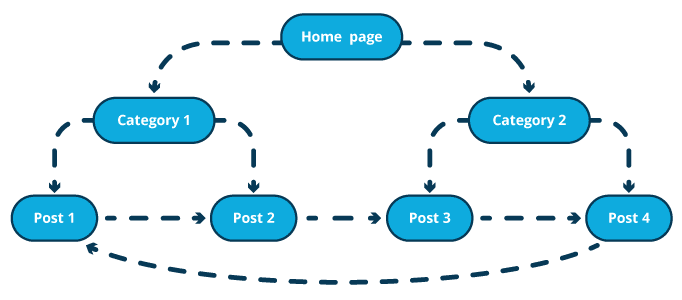

Orienter le Googlebot vers les pages stratégiques

Si l’arborescence de votre site doit avant tout être pensée pour l’utilisateur, négliger le comportement et les attentes des robots d’exploration serait une erreur.

Faciliter le passage des robots sur les pages piliers de votre site est un excellent moyen pour accélérer leur indexation. Les actions à réaliser pour se rendre sur les pages en question doivent être limitées à 3 maximum.

La qualité du maillage interne sera elle aussi déterminante pour le parcours des robots. Pour cette raison, les pages qui bénéficient de nombreux liens ne doivent pas être choisies au hasard.

Source : Oncrawl

Veiller à la précision du fichier robots.txt

Pour éviter une consommation inutile de budget de crawl, il est important d’indiquer via le fichier robots.txt l’ensemble des URL à ne pas explorer. Bloquer certaines URL permet de réorienter automatiquement le crawl vers des pages utiles.

Toutes les pages qui contiennent la balise ne sont pas indexées, mais elles sont bel et bien crawlées. N’hésitez pas à jeter un oeil à toutes ces pages non-indexées volontairement et à les écarter des robots d’exploration si nécessaire.

Pour optimiser votre budget de crawl, vous devez absolument connaître les pages qui sont visitées par les robots, et celles qui ne le sont pas. Si votre site n’est pas régulièrement crawlé par les Googlebots, cela implique sans doute que bon nombre de vos pages ne sont pas explorées, elle ne sont par conséquent ni indexées, ni classées… Donc invisibles pour les internautes : une sacré perte de trafic ! Votre positionnement sur la SERP se voit donc impacté négativement.

Une situation fréquente – et plutôt embêtante pour votre SEO – est que les robots indexent une quantité trop importante de pages d’une qualité moyenne ou faible.

Pour résumer, les 3 règles d’or à retenir absolument pour optimiser votre crawl budget sont :

- un contenu unique, original et pertinent,

- des mises à jour très régulières de votre site,

- une vitesse de chargement optimale de vos pages.

Vous souhaitez bénéficier de l’expertise de notre agence SEO pour optimiser votre budget de crawl et votre référencement naturel ? N’hésitez pas à nous contacter !